Blog-Eintrag -

Tech know-how to go: Wie europäisch ist "JUPITER"?

Der Superrechner JUPITER wird das erste ExaFlop-System in Europa sein – ein Rechner mit mindestens 1 Trillion Rechenoperationen pro Sekunde.

Das System wird von einem ParTec-Eviden Supercomputer-Konsortium bereitgestellt und im Jahr 2024 auf dem Campus des Forschungszentrums Jülich in Deutschland installiert. Das Gesamtbudget von 500 Millionen Euro umfasst Anschaffungs- und Betriebskosten, die Installation erfolgt 2024.

Das JUPITER-System wird aus zwei Rechenmodulen bestehen, einem Booster- und einem Cluster-Modul. Das Booster-Modul wird eine FP64-Leistung von 1 ExaFLOP/s liefern, gemessen mit dem HPL-Benchmark. Es implementiert eine hochskalierbare Systemarchitektur, die auf der neuesten Generation von NVIDIA-GPUs im Grace-Hopper-Superchip-Formfaktor basiert. Das universelle Clustermodul zielt auf Arbeitsabläufe ab, die entweder nicht von beschleunigerbasierten Berechnungen profitieren, oder auf große/komplexe Arbeitsabläufe, bei denen es entweder eine Mischung aus CPU- und GPU-Ausführungsphasen gibt, oder bei denen CPU-Prozessoren in der Peripherie bei der Vor- und Nachverarbeitung benötigt werden.

Darüber hinaus wird ein 21 Petabyte großes Flash-Modul (ExaFLASH) auf der Grundlage der IBM Storage Scale-Software und eine entsprechende Speicher-Appliance auf der Basis von IBM ESS 3500-Bausteinen bereitgestellt. Alle Rechenknoten von JUPITER sowie die Speicher- und Servicesysteme sind mit einer großen NVIDIA Mellanox InfiniBand NDR Fabric verbunden, die eine DragonFly+ Topologie implementiert.

Die oben beschriebene Systemkonfiguration ist das Ergebnis einer öffentlichen Ausschreibung, bei der frühere JSC-Systeme wie JUWELS, der Jülich Wizard on European Leadership Science, als Blaupause dienten. Die aktuelle JUWELS- und JSC-Benutzerbasis spielte eine Schlüsselrolle bei der Definition der Anforderungen, wobei eine große Anzahl von Benchmarks und Anwendungen für die Bewertung der Angebote herangezogen wurde.

Zusammenfassend ist JUPITER:

- der erste ExaFlop-Supercomputer in Europa

- das erste ExaFlop-System, der die von ParTec und dem Forschungszentrum Jülich entwickelte dynamische modulare System-Architektur (dMSA) nutzt

- das erste Exascale-Rechner, das von einem deutsch-französischen Konsortium aus ParTec und Eviden gebaut wird

- das erste Exascale-System, das den europäischen HPC-Prozessor Rhea von SiPearl nutzt

- der erste Exascale-Supercomputer, der sich vor allem aus europäischen Forschungs- und Entwicklungsleistungen speist

Die Technik im Detail, Quelle: JUPITER Technical Overview (fz-juelich.de)

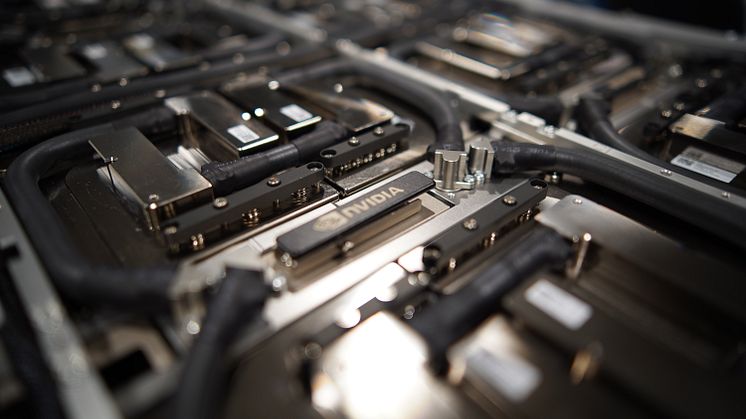

JUPITER Booster

Das Booster-Modul von JUPITER (kurz: der Booster) wird über etwa 6000 Rechenknoten verfügen, um die Rechenleistung von 1 ExaFLOP/s (FP64, HPL) zu erreichen - und noch viel mehr im Bereich der niedrigeren Genauigkeit (z. B. mehr als 90 ExaFLOP/s theoretische 8-Bit-Rechenleistung). Das Modul nutzt den NVIDIA Hopper-Grafikprozessor, die jüngste Generation der auf HPC ausgerichteten Allzweck-Grafikprozessoren von NVIDIA. Die GPUs werden im Grace-Hopper-Superchip-Formfaktor (GH200) eingesetzt, einer neuartigen, engen Kombination aus NVIDIAs erster CPU (Grace) und GPU der neuesten Generation (Hopper).

Jeder Booster-Knoten verfügt über vier GH200-Superchips, d. h. vier GPUs, die jeweils eng mit einer Partner-CPU verbunden sind (über NVLink Chip-to-Chip). Mit 72 Kernen pro Grace-CPU verfügt ein Knoten über insgesamt 288 CPU-Kerne (ARM). In einem Knoten sind alle GPUs über NVLink 4, alle CPUs über CPU NVLink-Verbindungen verbunden.

Die im System installierte Hopper H100-GPU-Variante bietet 96 GB HBM3-Speicher, der mit einer Bandbreite von 4 TB/s von den Multiprozessoren der GPU zugänglich ist. Im Vergleich zu früheren NVIDIA-GPU-Generationen bietet H100 mehr Multiprozessoren, größere Caches, neue Kernarchitekturen und weitere Weiterentwicklungen. Mit NVLink4 kann eine GPU Daten an jede andere GPU in einem Knoten mit 150 GB/s pro Richtung übertragen.

Jede GPU ist mit einer Grace-CPU verbunden, NVIDIAs erster HPC-CPU, die den ARM-Befehlssatz verwendet. Die Grace-CPU verfügt über 72 Neoverse-V2-Kerne, die SVE2-fähig sind und jeweils vier 128-Bit-Funktionseinheiten besitzen. Die CPU kann auf 120 GB des LPDDR5X-Speichers mit einer Bandbreite von 500 GB/s zugreifen. Das Hauptmerkmal des Superchip-Designs ist die enge Integration zwischen CPU und GPU, die nicht nur eine hohe Bandbreite (450 GB/s pro Richtung), sondern auch eine homogenere Programmierung ermöglicht.

Eine CPU ist mit den drei benachbarten CPUs in einem Knoten über CPU-NVLink-Verbindungen (cNVLink) verbunden, die 100 GB/s bieten. Eine weitere PCIe Gen 5-Verbindung besteht pro CPU zu ihrem zugehörigen InfiniBand-Adapter (HCA). In einem Knoten sind vier InfiniBand NDR HCAs der neuesten Generation mit jeweils 200 Gbit/s Bandbreite verfügbar.

Das System ist warmwassergekühlt und verwendet das BullSequana XH3000-Blade- und Rack-Design.

JUPITER Cluster

Das Cluster-Modul wird mehr als 1300 Knoten umfassen und eine Leistung von mehr als 5 PetaFLOP/s (FP64, HPL) erreichen. Das Silizium, das den Cluster antreibt, ist der Rhea1-Prozessor, ein Prozessor, der in Europa im Rahmen des EPI-Projekts entwickelt und von SiPearl vermarktet wurde. Rhea nutzt - wie Grace - die ARM-Befehlssatzarchitektur (ISA), mit der einzigartigen Fähigkeit, eine außergewöhnlich hohe Speicherbandbreite durch die Verwendung von HBM2e-Speicher zu bieten.

Jeder Cluster-Knoten verfügt über zwei Rhea1-Prozessoren, die auf der ARM Neoverse Zeus ISA basieren und skalierbare Vektor-Engines (SVE) für eine verbesserte Leistung bieten. Neben dem HBM-Speicher bietet jeder Knoten zusätzlich 512 GB DDR5-Hauptspeicher. Dedizierte Knoten mit 1 TB Hauptspeicher werden ebenfalls verfügbar sein.

Die Knoten basieren wiederum auf der BullSequana XH3000-Architektur und werden in den globalen NVIDIA Mellanox InfiniBand-Interconnect mit einem NDR200-Link pro Knoten integriert.

JUPITER Hochgeschwindigkeits-Verbundnetz

Im Kern des Systems verbindet das InfiniBand-NDR-Netzwerk 25 DragonFly+-Gruppen im Booster-Modul sowie insgesamt 2 zusätzliche Gruppen für das Cluster-Modul, den Speicher und die administrative Infrastruktur. Das Netz ist vollständig verbunden, mit mehr als 11000 globalen 400-Gb/s-Links, die alle Gruppen miteinander verbinden.

Innerhalb jeder Gruppe ist die Konnektivität maximiert, mit einer vollständigen Fat-Tree-Topologie.

Dabei nutzen die Leaf- und Spine-Switches dichte Quantum-2-NDR-Switches mit 64 Ports und 400 Gbit/s; die Leaf-Switches verwenden Split-Ports für die Verbindung mit 4 HCAs pro Knoten auf dem Booster-Modul (1 HCA pro Knoten auf dem Cluster-Modul), jeweils mit 200 Gbit/s.

Insgesamt umfasst das Netzwerk fast 51000 Links und 102000 logische Ports, mit 25400 Endpunkten und 867 High-Radix-Switches, und hat noch freie Ports für zukünftige Erweiterungen, zum Beispiel für weitere Rechenmodule.

Das Netzwerk wurde mit Blick auf HPC- und KI-Anwendungsfälle entwickelt. Sein adaptives Routing und seine fortschrittlichen netzinternen Rechenfunktionen ermöglichen eine sehr ausgewogene, skalierbare und kostengünstige Struktur für bahnbrechende wissenschaftliche Anwendungen.

ExaFLASH und ExaSTORE

JUPITER wird den Zugang zu mehreren Speichersystemen ermöglichen. Im Rahmen des JUPITER-Vertrags wird ein Speichersystem mit 21 PB nutzbarem Flash-Speicher mit hoher Bandbreite und niedriger Latenz als Scratch-Speicher bereitgestellt.

Der Scratch-Speicher basiert auf 40 IBM Elastic Storage Server 3500-Systemen, die NVMe-Festplattentechnologie verwenden und auf der IBM Storage Scale-Lösung basieren. Mit einer Rohkapazität von 29 PB und einer nutzbaren Kapazität von 21 PB bietet sie eine Schreibgeschwindigkeit von mehr als 2 TB/s und eine Lesegeschwindigkeit von 3 TB/s.

Darüber hinaus werden ein Hochleistungsspeichermodul mit einer Rohkapazität von mehr als 300 PB sowie eine Bandinfrastruktur für Sicherungs- und Archivierungszwecke mit einer Kapazität von über 700 PB bereitgestellt. Die Systeme werden direkt an JUPITER angeschlossen, sind aber Teil unabhängiger Beschaffungen. Für den Datenaustausch zwischen den einzelnen Speichersystemen werden dedizierte Server zur Verfügung stehen.

Service Partitionierung und System Management

Die Installation und der Betrieb von JUPITER wird über den einzigartigen JUPITER Management Stack erfolgen. Dieser ist eine Kombination aus Smart Management Center xScale (Atos/Eviden), ParaStation Modulo (ParTec) und Softwarekomponenten von JSC.

Für das Workload- und Ressourcenmanagement wird Slurm verwendet, erweitert um ParaStation-Komponenten. Das Rückgrat des Hintergrundmanagement-Stacks ist eine Kubernetes-Umgebung, die sich auf einen hochverfügbaren Ceph-Speicher stützt. Der Management-Stack wird für die Installation und Verwaltung aller Hardware- und Softwarekomponenten des Systems verwendet.

Mehr als 20 Login-Knoten werden den SSH-Zugang zu den verschiedenen Modulen des Systems ermöglichen. Darüber hinaus wird das System in die Jupyter-Umgebung am JSC integriert und über UNICORE verfügbar gemacht.